Trong một tháng kể từ khi OpenAI giới thiệu GPT-5, người dùng và chuyên gia đã phát hiện mô hình này liên tục bịa đặt thông tin cơ bản, từ dữ liệu GDP sai lệch đến sơ đồ nhãn sai trên hình ảnh. Các phương pháp đánh giá hiện tại được cho là khuyến khích phỏng đoán hơn trung thực.

Điểm nổi bật:

- GPT-5 thường xuyên tạo ra thông tin sai lệch về dữ liệu cơ bản.

- Cơ chế đánh giá hiện tại khuyến khích phỏng đoán thay vì trung thực.

- Người dùng và chuyên gia phát hiện các ảo giác qua thử nghiệm và tương tác.

- Việc bịa đặt thông tin gây mất niềm tin và yêu cầu xác minh chéo.

- GPT-5 không đạt trình độ trí tuệ cấp tiến sĩ như tuyên bố.

Trong một tháng kể từ khi OpenAI giới thiệu GPT-5, người dùng và chuyên gia đã phát hiện mô hình này liên tục bịa đặt thông tin cơ bản, từ dữ liệu GDP sai lệch đến sơ đồ nhận sai trên hình ảnh. Các phương pháp đánh giá hiện tại được cho là khuyến khích phỏng đoán hơn trung thực.

Điểm nổi bật:

- GPT-5 thường xuyên tạo ra thông tin sai lệch về dữ liệu cơ bản.

- Cơ chế đánh giá hiện tại khuyến khích phỏng đoán thay vì trung thực.

- Người dùng và chuyên gia phát hiện các ảo giác qua thử nghiệm và tương tác.

- Việc bịa đặt thông tin gây mất niềm tin và yêu cầu xác minh chéo.

- GPT-5 không đạt trình độ trí tuệ cấp tiến sĩ như tuyên bố.

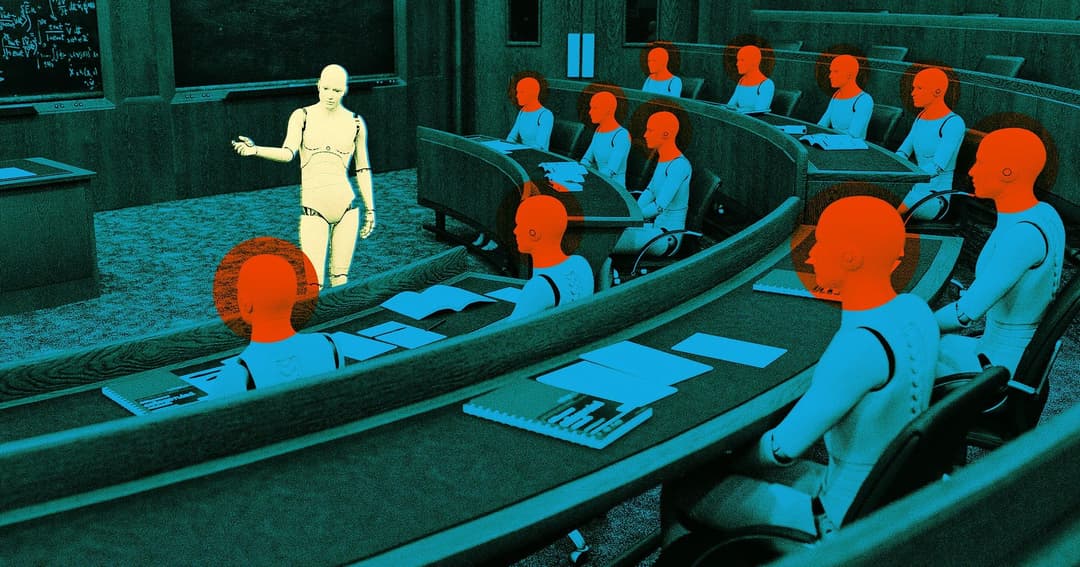

GPT-5 và các ảo giác

Chỉ hơn một tháng kể từ khi OpenAI bỏ mô hình ngôn ngữ lớn GPT-5 được chờ đợi từ lâu, nó đã không ngừng phun ra một lượng lớn những điều sai lệch kỳ lạ kể từ đó. Từ các chuyên gia AI tại Trung tâm Trí tuệ nhân tạo Walter Bradley của Viện Khám phá đến những người dùng Reddit trên r/ChatGPTPro, có rất nhiều bằng chứng cho thấy tuyên bố của OpenAI rằng GPT-5 tự hào có "trí thông minh cấp tiến sĩ" đi kèm với một số hạn chế nghiêm trọng.

Nguyên nhân và giải thích của OpenAI

Trong một bài đăng trên blog gần đây về ảo giác, OpenAI một lần nữa tuyên bố rằng GPT-5 tạo ra "ít hơn đáng kể" các ảo giác so với trước, đồng thời giải thích rằng:

"Ảo giác vẫn tồn tại một phần vì các phương pháp đánh giá hiện tại đặt ra các động cơ sai. Hầu hết các đánh giá đều đo lường hiệu suất của mô hình theo cách khuyến khích phỏng đoán hơn là trung thực về sự không chắc chắn."

Ví dụ: Dữ liệu GDP sai lệch

Người dùng Reddit chia sẻ rằng họ đã gặp phải các lỗi thực tế lớn khi hỏi về tổng sản phẩm quốc nội (GDP) của các quốc gia khác nhau và được chatbot trình bày với "số liệu gấp đôi giá trị thực tế theo đúng nghĩa đen". Ví dụ, Ba Lan được liệt kê là có GDP hơn hai nghìn tỷ đô la, trong khi trên thực tế, GDP của nước này theo Quỹ Tiền tệ Quốc tế chỉ dao động quanh mức 979 tỷ đô la.

Thử nghiệm với hình ảnh túi có túi

Người hoài nghi AI Gary Smith của Trung tâm Walter Bradley đã thực hiện ba thí nghiệm đơn giản với GPT-5: một trò chơi tic-tac-toe đã được sửa đổi, đặt câu hỏi về lời khuyên tài chính và yêu cầu vẽ một con túi có túi với năm bộ phận cơ thể được dán nhãn. Trong cả hai trường hợp, GPT-5 đều gắn nhãn sai hoặc mô tả những hình ảnh không chính xác, chứng tỏ mô hình còn xa mới đạt trình độ chuyên môn cấp tiến sĩ.

Kết luận và khuyến nghị

Có vẻ khá rõ ràng từ khía cạnh này của bản phát hành GPT-5 rằng nó không thông minh bằng một ứng cử viên tiến sĩ, hoặc chí ít là không đạt đến trình độ như tuyên bố. Câu chuyện nhấn mạnh tầm quan trọng của việc kiểm tra thực tế bất cứ thông tin nào mà chatbot này cung cấp.

Tác động đối với cộng đồng và thị trường Việt Nam

Việc GPT-5 liên tục tạo ra thông tin sai lệch và các ảo giác có thể ảnh hưởng tiêu cực đến lòng tin của người dùng Việt Nam vào công nghệ AI. Trong bối cảnh ngày càng nhiều doanh nghiệp và tổ chức nghiên cứu ứng dụng trí tuệ nhân tạo tại Việt Nam, việc phụ thuộc vào dữ liệu không chính xác có thể dẫn đến quyết định sai lầm, lãng phí nguồn lực và gián đoạn quy trình vận hành.

Đối với cộng đồng phát triển công nghệ, tình trạng này cũng đặt ra thách thức lớn về chuẩn mực đào tạo và đánh giá mô hình AI: cần ưu tiên tính minh bạch và khả năng xác minh thông tin thay vì chỉ tập trung vào hiệu suất đầu ra. Đồng thời, người dùng cá nhân, từ học sinh, sinh viên đến chuyên gia, cần nâng cao nhận thức về kiểm chứng thông tin, không chấp nhận kết quả do chatbot đưa ra một cách thụ động mà nên đối chiếu với nguồn tin cậy.

Về lâu dài, doanh nghiệp Việt Nam khi triển khai các giải pháp tự động hóa và dịch vụ AI cần kết hợp nhiều công cụ giao tiếp và kiểm định, đồng thời xây dựng quy trình đánh giá nội bộ để giảm thiểu rủi ro. Chỉ khi đảm bảo chất lượng dữ liệu, AI mới thực sự phát huy được tiềm năng, hỗ trợ hiệu quả cho chuyển đổi số tại Việt Nam.